-

体系认证

- ISO/IEC 42001 人工智能管理体系

- ISO21434 道路车辆-信息安全工程体系

- ITSS运行维护标准

- ITSS咨询设计标准

- ITSS数据中心标准

- ITSS云计算服务能力标准

- CMMI软件能力成熟度评估

- ISO27701隐私信息管理

- ISO27001信息安全管理

- ISO22301业务连续性管理

- ISO20000信息技术服务管理

- ISO27017云服务信息安全

- ISO27018公有云隐私安全

- ISO27040存储安全管理体系

- ISO9001质量管理

- ISO14001环境管理

- ISO45001职业健康安全管理

- ISO29151个人身份信息保护指南

- ISO38505数据治理安全管理

- 商品售后服务评价体系

- 知识产权管理体系

- ISO27799健康信息安全管理体系

- GB/T35273 个人信息安全规范认证

- 资质认定

- 管理培训

- 解决方案

《数据安全能力成熟度模型》过程域04:数据质量管理

2019年8月30日,《信息安全技术 数据安全能力成熟度模型》(GB/T 37988-2019)简称DSMM(Data Security Maturity Model)正式成为国标对外发布,并已于2020年3月起正式实施。

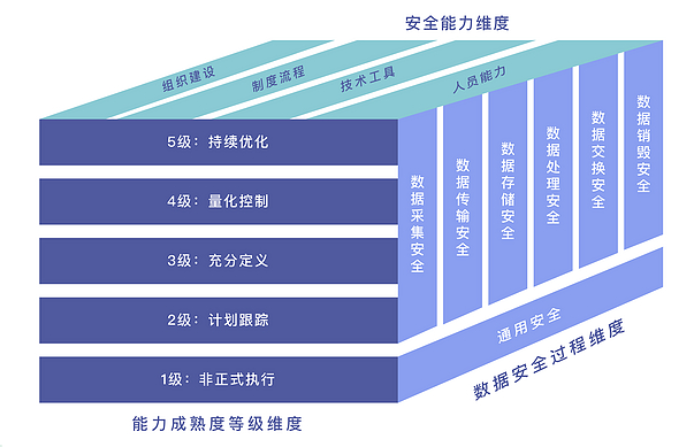

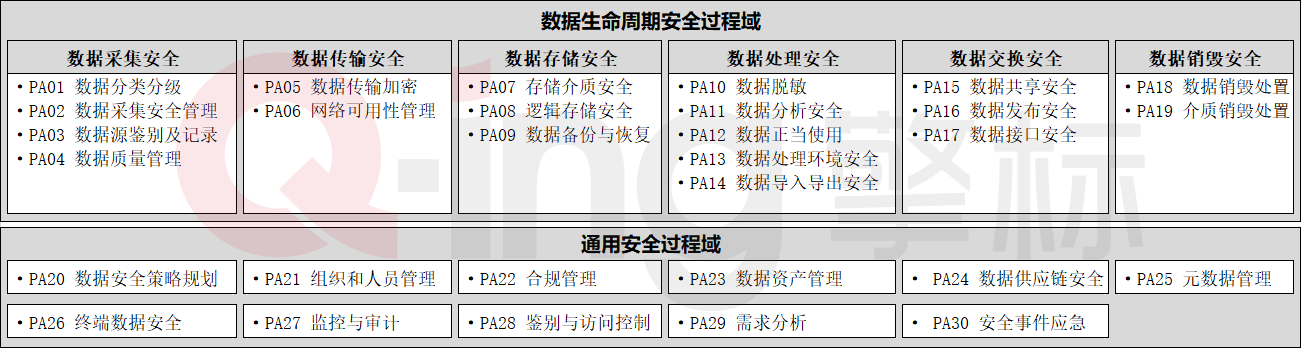

DSMM将数据按照其生命周期分阶段采用不同的能力评估等级,分为数据采集安全、数据传输安全、数据存储安全、数据处理安全、数据交换安全、数据销毁安全六个阶段。DSMM从组织建设、制度流程、技术工具、人员能力四个安全能力维度的建设进行综合考量。DSMM将数据安全成熟度划分成了1-5个等级,依次为非正式执行级、计划跟踪级、充分定义级、量化控制级、持续优化级,形成一个三维立体模型,全方面对数据安全进行能力建设。

在此基础上,DSMM将上述6个生命周期进一步细分,划分出30个过程域。这30个过程域分别分布在数据生命周期的6个阶段,部分过程域贯穿于整个数据生命周期。

本系列文将以DSMM数据安全治理思路为依托,针对上述各过程域,基于充分定义级视角(3级),提供数据安全建设实践建议,本文作为本系列第四篇文章,将介绍数据采集安全阶段的数据数据质量管理过程域(PA04)。

一、定义

数据质量管理,DSMM官方描述定义为建立组织的数据质量管理体系,保证对数据采集过程中收集/产生的数据的准确性、一致性和完整性。

DSMM标准在充分定义级对数据质量管理要求如下:

(1)组织建设

组织应设立数据质量管理岗位和人员,负责制定统一的数据质量管理要求,明确对数据质量进行管理和监控的责任部门或人员。

(2)制度流程

1)应明确数据质量管理相关的要求,包含数据格式要求、数据完整性要求、数据源质量评价标准等;

2) 应明确数据采集过程中质量监控规则,明确数据质量监控范围及监控方式;

3) 应明确组织的数据淸洗、转换和加载操作相关的安全管理规范,明确执行的规则和方法、相关人员权限、完整性和一致性要求等。

(3)技术工具

应利用技术工具实现对关键数据进行数据质量管理和监控,实现异常数据及时告警或更正。

(4)人员能力

负责该项工作的人员应了解数据采集阶段的数据质量控制要素,能够基于组织的业务特点开展数据质量评估工作。

二、实践指南

(1)组织建设

组织机构需要专门设立一个数据质量管理岗位并招聘一个或多个数据质量管理人员,数据质量管理岗位的相关人员需要为公司建立属于自己的数据质量管理体系,负责为公司制定统一的数据质量管理规范,推动数据质量管理制度的有效落地,明确责任主体,明确对数据质量进行监督、管理的相关责任人或责任部门。

(2)人员能力

针对该项工作的相关人员,需要熟悉国家网络安全法律法规以及组织机构所属行业的政策和监管要求,在进行数据质量管理的过程中严格按照《网络安全法》、《数据安全法》等相关国家法律法规和行业规范执行,同时还需要此岗位的相关人员具备良好的数据安全风险意识,了解当前行业内数据质量管理的最佳实践路线,了解数据采集阶段中的数据质量控制要素,对数据质量管理规范有一致性理解,能够根据组织机构的实际数据质量管理需求以及组织机构不同业务的特点开展数据质量评估工作。

(3)落地执行性确认

针对数据质量管理岗位人员能力的实际落地执行性确认,可通过内部审计、外部审计等形式以调研访谈、问卷调查、流程观察、文件调阅、技术检测等多种方式实现。

(4)制度流程

1)数据质量评估八个维度

数据质量可以从八个维度进行衡量,分别是真实性、完整性、规范性、一致性、准确性、唯一性、关联性、及时性。

① 真实性:数据必须真实准确的反映客观的实体存在或真实的业务,是一切管理工作的基础。数据的真实性取决于数据采集过程的可控程度高,可追溯情况好,数据的真实性容易得到保障,而可控程度低或者无法追溯,数据造假后无法追溯,则真实性难以保证。

② 完整性:数据的完整性是从数据采集到的程度来衡量的,用于度量哪些数据丢失了或者哪些数据不可用

③ 规范性:数据的规范性可用于度量哪些数据未按统一格式存储。

④ 一致性:数据的一致性可用于度量哪些数据的值在信息含以上是冲突的。例如,相同的数据有多个副本的情况下的数据不一致,便会存在数据内容冲突的问题。

⑤ 准确性:数据的准确性是指数据采集值或者观测值和真实值之间的接近程度,数据的准确性由数据的采集方法决定。

⑥ 唯一性:数据的唯一性用于识别和度量重复数据、冗余数据。重复数据是导致业务无法协同、流程无法追溯的重要因素,也是数据治理需要解决的最基本的数据问题。

⑦ 关联性:数据的关联性包括函数关系、相关系数、主外键关系、索引关系等。存在数据关联性问题,会直接影响数据分析的结果,进而影响管理决策。

⑧ 及时性:数据的及时性是指能否在需要的时候获到数据,数据的及时性与企业的数据处理速度及效率有直接的关系,是影响业务处理和管理效率的关键指标。

2)数据质量校验

数据质量校验是指实现数据的完整性和一致性检查,提升数据质量。

数据质量校验的的规则如下:

① 关联性检查:key值关联是否存在;

② 行级别:数据量是否一致;

③ 列级别:表结构是否一直,如字段数量、字段类型和宽度等是否一致;

④ 内容级别:数据内容是否一致,以及是否数据内容是否缺失。

数据质量校验可分为三个层次:

① 人工对比:为了检查数据的正确性,相关负责人员可打开相关数据库,对转换前和转换后的数据进行直接的对比,发现数据不一致时,通知相关人员进行纠正;

② 程序对比:为了自动化地检查数据的质量,更好的进行测试对比,可利用程序对转换前和转换后的数据进行对比,发现数据不一致时,通知相关人员进行纠正;

③ 统计分析:为了更加全面地从总体上检查数据的质量,需要通过统计分析的方法,主要通过对新旧数据不同角度、不同视图的统计对数据转换的正确程度进行量化的分析,发现其在某个统计结果的不一致性,通知相关人员进行纠正。

数据质量校验的流程如下:

① 对待校验的数据源进行解析,得到数据源的元数据;

② 配置检验规则,例如数据唯一性校验、完整性校验、精度校验或格式校验、长度校验等;

③ 根据数据源的元数据对数据源进行校验运算,得到校验结果。

3)数据清洗

数据清洗是指发现并纠正数据文件中可识别的错误的最后一道程序,包括检查数据的一致性,以及处理无效值和缺失值等。

数据清洗的规则如下:

① 缺失值处理:

a. 根据同一字段的数字填充,例如均值、中位数、众数;

b. 根据其他字段的数据填充,例如通过身份证件号码取出生日期等;

c. 设定一个全局变量,例如缺失值用“unknown”等填充;

d. 直接剔除,避免缺失值过多影响结果;

e. 建模法,可以用回归、使用贝叶斯形式化方法的基于推理的工具或决策树归纳确定;

② 重复值处理:

a. 根据主键去重,利用工具去除重复记录的数据;

b. 根据组合去重,编写一系列的规则,对重复情况复杂的数据进行去重;

③ 异常值处理:

a. 根据同一字段的数据填充,例如均值、中位数、众数等;

b. 直接剔除,避免异常值过多影响结果;

c. 设为缺失值,可以按照处理缺失值的方法来处理;

④ 不一致值处理

a. 从根源入手,建立统一的数据体系;

b. 从结果入手,设立中心标准,对不同来源数据进行值域对照;

⑤ 丢失关联值处理

a. 重新建立关联。

4)数据质量管理规范

组织开展数据质量管理的过程中应遵循如下基本要求,提高数据质量:

① 设立负责数据质量管理的岗位和人员,负责制定数据质量管理规范以及对数据质量进行管理和监控,数据采集质量管理规范中需包含但不限于数据格式要求、数据完整性要求、数据质量要素、数据源质量评价标准;

② 对数据质量进行管理时,需要对数据的真实性、完整性、规范性、一致性、准确性、唯一性、关联性、及时性进行定义和监控;

③ 建立数据采集过程中质量监控规则,明确数据质量监控范围及监控方式。

④ 设置数据质量校验和监控方法,例如人工对比、程序对比、统计分析等;

⑤ 设置数据质量异常上报流程和操作规范,并对每个已报告异常的解决状态保持跟踪;

⑥ 根据实际情况,设置数据清洗的规则和方法;

5)数据质量管理实施流程

提高数据质量最好的方法是首先根据要分析的目标确定数据希望达到的标准,根据这些标准衡量现有的数据集,然后使用各种提高数据质量的技术和方法,持续不断地提高数据的质量,以达到预定义的标准,下面介绍一种常用的数据质量管理项目的实施流程。

① 发现数据质量问题,这是实施数据质量管理的第一步;

② 分析与数据质量相关的业务环节;

③ 分析现有数据的数据质量,收集数据质量管理需求;

④ 设计项目使用的技术平台,这可从软件应用商购买或自行开发;

⑤ 建立元数据模型;

⑥ 建立数据质量管理系统架构;

⑦ 评估数据质量管理程序的运行结果;

⑧ 清洗数据;

⑨ 持续监视数据;

(5)技术工具简述

数据质量是保证数据应用效果的基础。衡量数据质量的指标体系有很多,几个典型的指标有:完整性(数据是否缺失)、规范性(数据是否按照要求的规则存储)、一致性(数据的值是否存在信息含义上的冲突)、准确性(数据是否错误)、唯一性(数据是否是重复的)、时效性(数据是否按照时间的要求进行上传)。数据质量是描述数据价值含量的指标,就像铁矿石的质量,矿石的质量高,则练出来的钢材就会多;反之,矿石的质量低,不但练出来的钢材少了,同时也增加了提炼的成本。因此必须要对数据质量进行管理,目前主要通过数据清洗工具进行数据质量核查。

1)数据清洗工具

所谓数据清洗,其目的是检测数据集合中存在的不符合规范的数据,并进行数据修复,提高数据质量。针对数据清洗一般是自动完成,只有少数情况下需要人工参与完成,提高数据质量。根据数据常见的缺陷类型,可以把数据清洗方法分为五类:解决空值数据的方法、解决错误数据的方法、解决重复数据的方法、解决不一致数据的方法、解决数据不规范的方法。

① 解决空值数据的方法:

进行估算填充。而估算方法又包括样本均值、中位数、众数、最大/最小值填充,这种方法在没有更多信息参考时可以采用,但是有一定误差,如果空值数量较多,则会对结果造成影响,使结果偏离实际情况。

② 解决错误值数据的方法:

需要用一定方法识别该错误值,常用统计方法进行分析,统计工具有很多,例如偏差分析、回归方程、正态分布等,也可以用简单的规则库检查数值范围,使用属性间的约束关系来识别和处理数据。

③ 解决重复数据的方法:

如果判断重复记录则涉及到实体识别技术。完全相同的记录即指向相同实体,而对于有一定相似度的数据,有可能指向同一实体,例如对同一数据采用不同的计量单位,需要采用有效的技术诊断识别。而可能存在一种极端的情况,即不相同的两条记录,可能反映了同一实体的不同观测点,清洗时需要进行数据合并。

④ 解决不一致数据的方法:

数据不满足完整性约束,可以通过分析数据结构,元数据文档,得到数据之间的关联关系,并制定同一的标准。

⑤ 解决数据不规范的方法:

不同行业的数据规范要求都不相同,一般来说,我们可以通过自定义的规则来定制化实现不同行业的数据规范性要求。如某个表列中的数据内容为手机号,那我们就可以明确该数据的规范格式要11个数字字符,可以通过相关正则表达式进行实现,从而自动化的对该表列中内容进行实时监控。

扫码微信咨询

扫码微信咨询